Массовая проверка robots.txt на доступность URL для Google

Начните с 3$ бесплатноЗарегистрируйтесь и получите бесплатно 857 SEO проверок URL

или 600 проверок индексации в Google.

Как проверить правила в robots.txt для каждой из страниц

Если у вас большое количество страниц с обратными ссылками которые вы хотели бы проверить на доступность для поисковых систем и наличие директив noindex и nofollow в файле robots.txt, то в ручном режиме это займет уйму времени. HyperChecker предлагает автоматизировать этот процесс и получить результаты проверки за несколько минут.

Для проверки правил файла robots.txt мы предлагаем два инструмента.

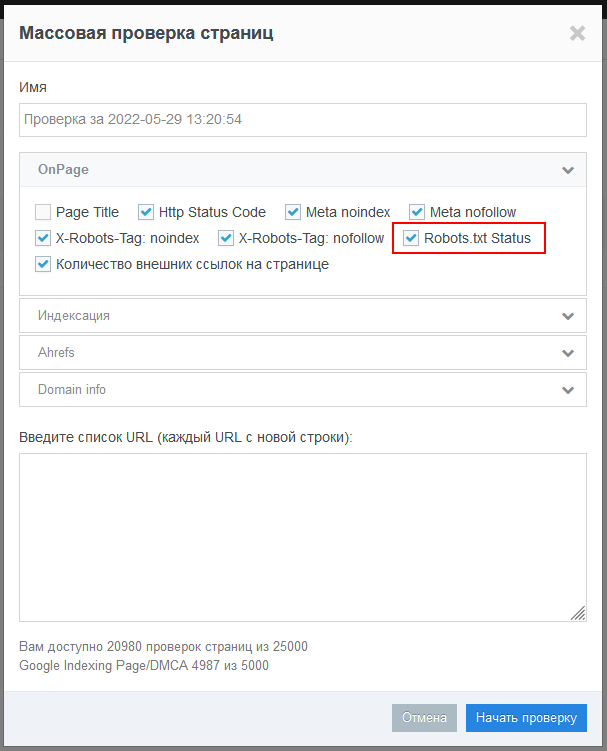

Первый инструмент — Массовая проверка страниц. Это простая одноразовая проверка страниц по ключевым СЕО параметрам:

- Директивы nofollow/noindex в Meta Tag и X-Robots-Tag;

- Количество исходящих ссылок;

- Статус индексации страниц в Google;

- Запрет на показ страницы через жалобы DMCA;

- Интегрированные данные из Ahrefs;

- Top-Level-Domain, IP адрес и страна размещения веб-сайта;

- Http статус код.

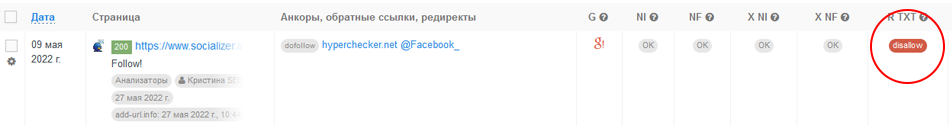

Второй инструмент — автоматический мониторинг обратных ссылок. Сюда входят те же проверки что и в первом случае, но еще добавлен поиск обратных ссылок на странице на ваш веб-сайт. В отчете вы увидите сколько и каких анкоров имеется у вашего проекта и доступны ли они для поисковых систем в атрибуте rel(nofollow/dofollow/sponsored и т.д.).

В настройках проекта можно настроить частоту проверки обратных ссылок чтобы всегда быть в курсе того, какие ссылки пропали, стали недоступны для поисковых систем или получили запрет на сканирование и индексацию для поисковых роботов согласно правил файла robots.txt.

Для чего линкбилдеру проверять правила файла robots.txt

Для проверки noindex nofollow в файле robots.txt есть несколько причин.

Оптимизация бюджета и восстановление работы обратных ссылок

Вебмастера, которые размещают гостевые посты на своих сайтах, часто вносят технические изменения в его работу. Не редки случаи когда по ошибке, либо намеренно, страница с вашим гостевым постом может получить запрет на сканирование и индексацию в файле robots.txt. Такая страница обязательно выпадет из поиска и перестанет передавать вес, что в дальнейшем приведет к понижению позиций вашего основного сайта в поисковых системах.

Пользы от таких гостевых постов — ноль, а деньги будут потрачены в пустую. Необходимо регулярно и вовремя выявлять страницы которые запрещены в robots.txt и писать вебмастерам, чтобы они вернули исходные параметры страниц с вашими обратными ссылкам. В таком случае вы минимизируете негативный эффект на продвижение своего проекта. Если же вебмастер не идет на контакт, вы можете открыть диспут и затребовать возврат потраченных денег. Это отлично работает в денежной системе PayPal.

Повторение ссылочной массы как у конкурентов

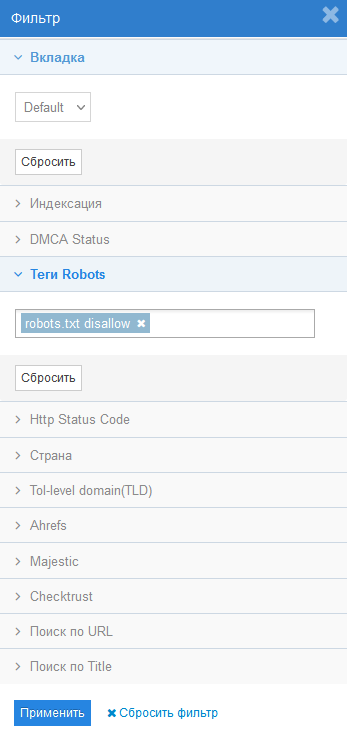

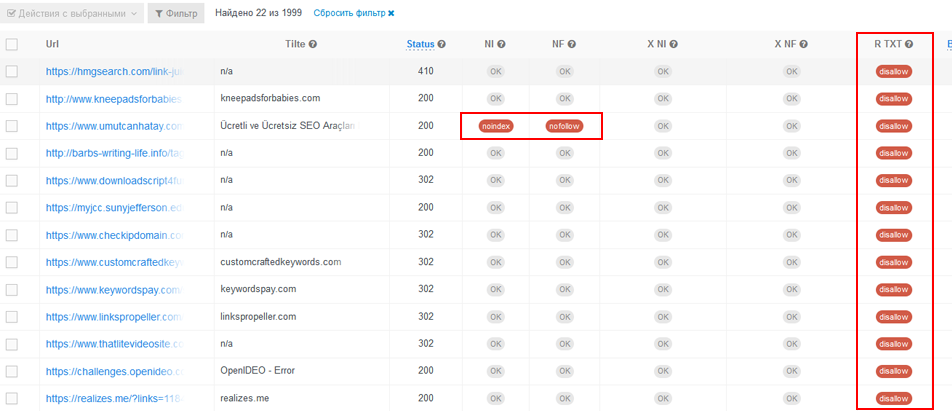

Если вы хотите разместить обратные ссылки на тех же площадках, на которых размещаются конкуренты, то здесь инструмент HyperChecker подойдет как никогда. Обратные ссылки конкурента могут быть заблокированы в файле robots.txt либо иметь запрет на индексацию в мета тегах или X-Robots-Tag. Они не принесут никакой пользы для вас, а лишь истощат ваш бюджет.

Чтобы отсеять такие ссылки, необходимо загрузить их в чекер HyperChecker, и отфильтровать все то, что не разрешено в robots.txt и мета тегах. При желании можно воспользоваться фильтром по данным Ahrefs, исходящим ссылкам, по статусу индексации и т.д.

В итоге, вы не потратите деньги на безполезные гостевые посты и получите только те площадки, на которых ваши обратные ссылки будут приносить пользу для вашего проекта.