Інструмент для масової перевірки сторінок на заборону noindex nofollow у robots.txt

Спробуйте з 3$ безкоштовноЗареєструйтеся та отримайте безкоштовно 857 SEO перевірок URL

або 600 перевірок індексації в Google.

Як масово перевірити правила у robots.txt

Якщо у вас велика кількість сторінок зі зворотними посиланнями, які ви хотіли б перевірити на доступність для пошукових систем і наявність директив noindex і nofollow у файлі robots.txt, то в ручному режимі це займе багато часу. HyperChecker пропонує автоматизувати цей процес та отримати результати перевірки за кілька хвилин.

Для перевірки правил у файлі robots.txt ми пропонуємо два інструменти.

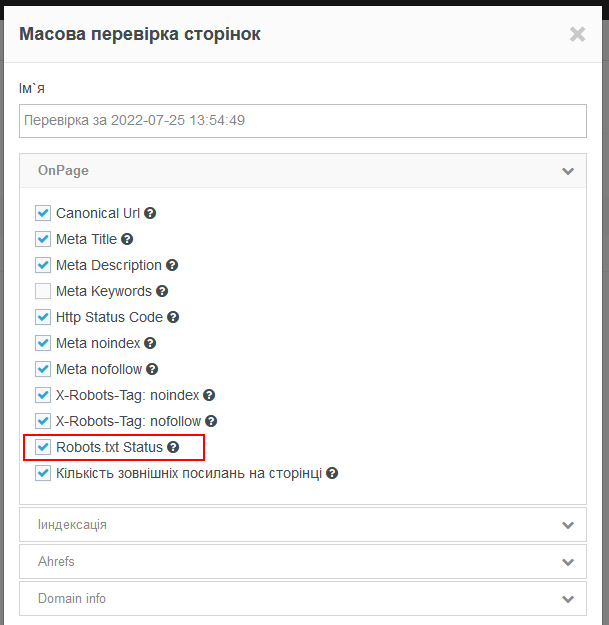

Перший інструмент – Масова перевірка сторінок. Це проста одноразова перевірка сторінок за ключовими параметрами СЕО:

- Директиви nofollow/noindex у Meta Tag та X-Robots-Tag;

- Кількість вихідних посилань;

- Перевірка індексації сторінок у Google;

- Заборона на показ сторінки через скарги DMCA;

- Інтегровані дані з Ahrefs;

- Top-Level-Domain, IP адреса та країна розміщення веб-сайту;

- Http статус код.

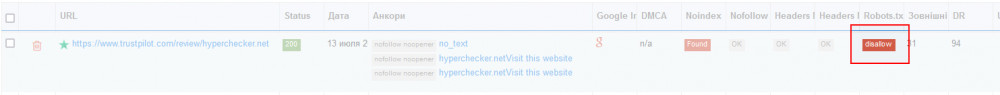

Другий інструмент – автоматичний моніторинг зворотних посилань. Сюди входять ті ж перевірки, що і в першому випадку, але ще доданий пошук зворотних посилань на сторінці на ваш веб-сайт. У звіті ви побачите, скільки і яких анкорів є у вашого проекті і чи доступні вони для пошукових систем в атрибуті rel(nofollow/dofollow/sponsored і т.д.).

У налаштуваннях проекту можна налаштувати частоту перевірки зворотних посилань, щоб завжди бути в курсі, які посилання зникли, стали недоступними для пошукових систем або отримали заборону на сканування та індексацію для пошукових роботів згідно з правилами файлу robots.txt.

Для чого перевіряти правила файлу robots.txt

Для перевірки noindex та nofollow у файлі robots.txt є кілька причин.

Оптимізація бюджету та відновлення роботи зворотних посилань

Вебмайстри, які розміщують гостьові пости на своїх сайтах, часто вносять технічні зміни до його роботи. Не рідкісні випадки коли помилково, або навмисно, сторінка з вашим гостьовим постом може отримати заборону на сканування та індексацію у файлі robots.txt. Така сторінка обов'язково випаде з пошуку та перестане передавати вагу, що надалі призведе до зниження позицій вашого сайту у пошукових системах.

Користі від таких гостьових постів — нуль, а гроші будуть витрачені на вітер. Необхідно регулярно і вчасно виявляти сторінки, які заборонені в robots.txt і писати вебмайстрам, щоб вони повернули вихідні параметри сторінок з вашими зворотними посиланнями. У такому разі ви мінімізуєте негативний ефект на просування вашого проекту. Якщо вебмастер не йде на контакт, ви можете відкрити диспут і вимагати повернення витрачених грошей. Це добре працює у платіжній системі PayPal.

Розміщення посилань на тих сайтах, те розміщуються конкуренти

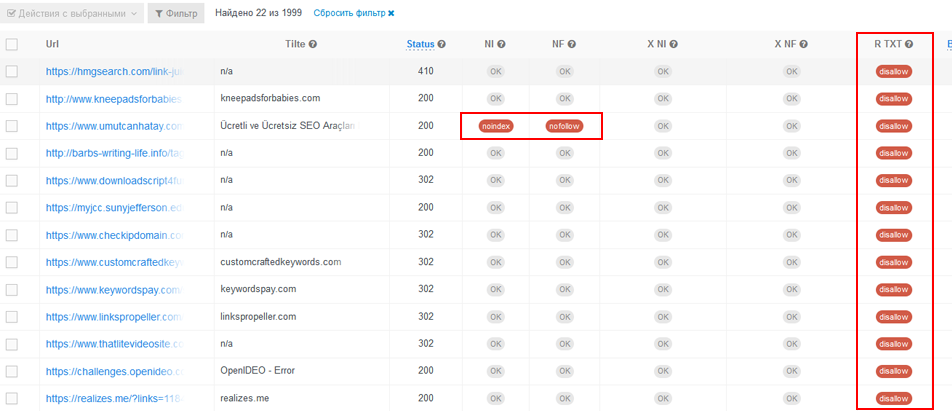

Якщо ви хочете розмістити зворотні посилання на тих же майданчиках, на яких розміщуються конкуренти, то інструмент HyperChecker підійде як ніколи. Зворотні посилання конкурента можуть бути заблоковані у файлі robots.txt або мати заборону на індексацію в мета тегах або X-Robots-Tag. Звісно, на таких майданчиках не потрібно розміщувати статті та посилання.

Щоб відсіяти такі посилання, необхідно завантажити їх у HyperChecker і відфільтрувати все те, що не дозволено в robots.txt і мета тегах.

У результаті ви не витратите гроші на марні гостьові пости і отримаєте тільки ті майданчики, на яких ваші зворотні посилання будуть приносити користь для вашого проекту.